AIモード(AI Mode) – Logo

Neon-gradient toggle (ON) with activation waves and mini dial on dark #050913, for “AIモード”.

AI

MODE

AIモード(AI Mode)

ON → ASSIST → AUTONOMY

Context × Control × Safety

AIモード(AI Mode) について、Googleの公開資料(論文・特許・公式ブログ・公開PDF)にもとづき、その仕組みをD professions’ AI®︎が技術的かつ分かりやすく整理し、企業・経営陣がとるべきAIモード(AI Mode)対策を解説します。

AIモード(AI Mode)とは

GoogleのAIモード(AI Mode)とは、生成要約をSERP上に差し込むAI による概要(AI Overviews) の枠を超え、長文・多段の探索、マルチモーダル入力、フォローアップによる深掘り、さらには外部サイトでのタスク完遂(予約・購入・申し込み等)までを射程に入れた専用タブ型のエンドツーエンドAI検索体験 です。

AIモード(AI Mode)のログイン方法と使い方

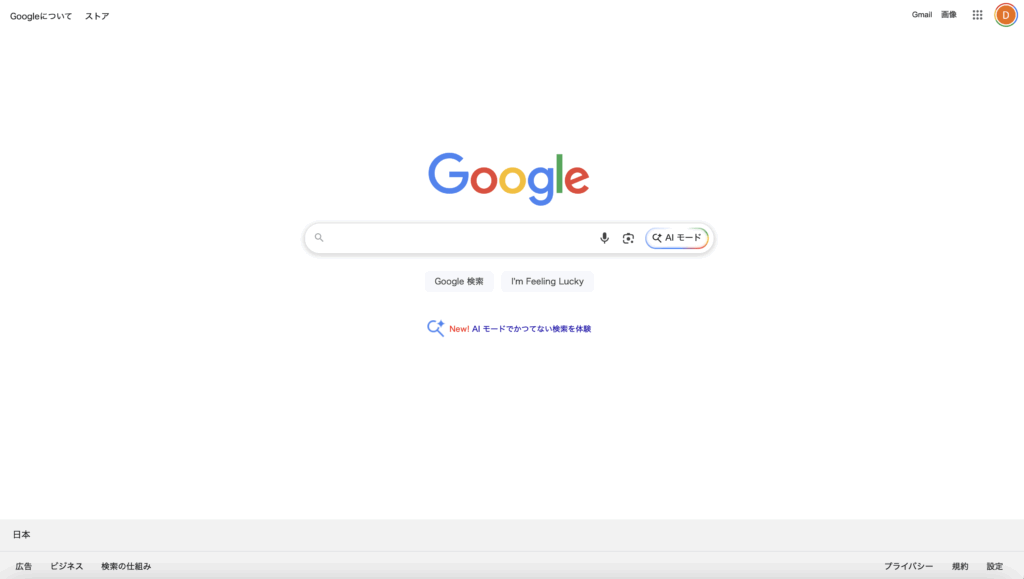

(1) https://www.google.com にアクセスすれば、AIモード(AI Mode)に、ログインは特に不要。(下図)

(2)AIモード(AI Mode)に聞きたいことを入力し、「AIモード」ボタンを押します。(下の動画は実際のAIモード(AI Mode))

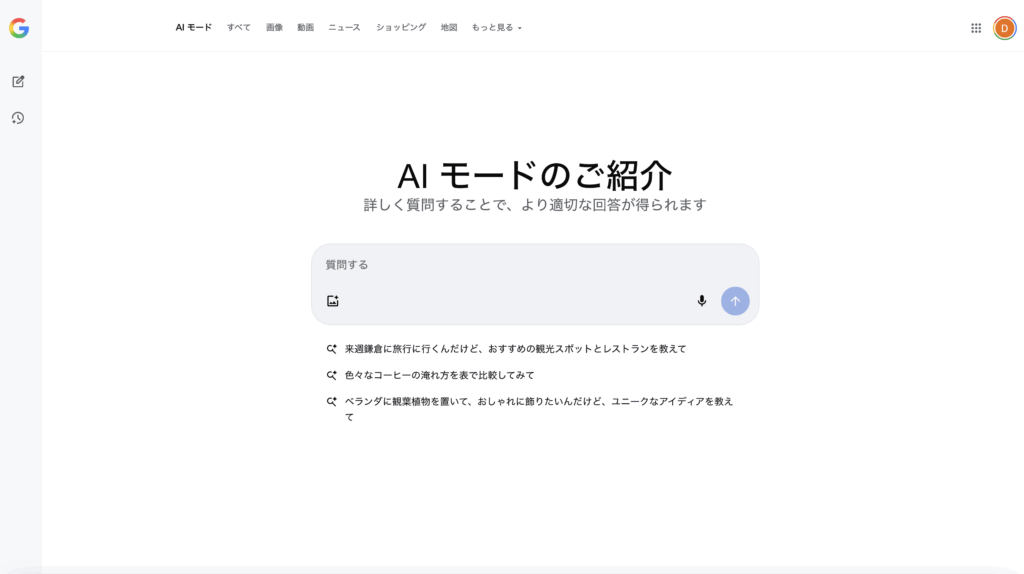

(3)また、 https://www.google.com/search?udm=50 にアクセスすれば、AIモード(AI Mode)がメインで使えます(下図)

Google AIモード(AI Mode)

専用タブ型エンドツーエンドAI検索体験

通常タブ

検索結果

AI モード

従来検索

AIによる概要

SERP統合

AI モード

完全統合型

AI モード

Core Engine

AI検索

長文・多段探索

Complex Query

段階的分析処理

マルチモーダル

Multi-Input

画像・音声・テキスト

フォローアップ

Deep Dive

対話的深掘り

タスク完遂

Task Execution

予約・購入・申込

GoogleのAIモード(AI Mode)は、検索結果ページの一部として生成要約を差し込むAI Overviewsを起点に、より能動的で連続的な探索体験へ踏み出すAI主導の検索タブとして設計されています。

基盤にはカスタム版のGeminiモデルがあり、既存の検索ランキングや品質システム、ナレッジグラフと連携して、自然文の応答とともに検証用のウェブリンクを提示します。

AI による概要(AI Overviews) がSERP内のスナップショットであるのに対して、AIモード(AI Mode)はフォローアップでの深掘り、マルチモーダル入力、計画・比較・実行までの情報ジャーニーを前提にしたエンドツーエンドの体験として位置づけられています。公式資料でも、AI による概要(AI Overviews) とAIモード(AI Mode)は同じ基盤を共有しつつ、後者はより高度な推論とマルチモーダリティを前面に出す最も強力なAI検索として説明されています。

AIモードとAI による概要

連続体としてのGoogle検索

AI による概要 は、検索結果に生成要約 を付与し、根拠リンク(ウェブへの送客)を伴う要点のまとめを返す機能。Googleの既存ランク付け・Knowledge Graph と連携し、Gemini系カスタムモデル が生成に用いられる。利用者はリンクからより深く学べる設計。運用ではポリシー/スパム対策/トリガリング により表示可否が制御される。

AIモード(AI Mode)は、Search内の新しい専用タブ として提供される、より推論的・多段的・マルチモーダル な検索体験。エージェント的タスク ・個人コンテキスト(オプトイン) ・カスタム可視化 など拡張機能が段階的に入り、先端機能をまずAI Modeで試し、成熟後にコア検索へ還流するロードマップが示されている。

AIモード(AI Mode)の内部ではGemini系のカスタムモデル が、従来のランキングやナレッジグラフ、品質・安全システムと密結合し、根拠リンクを備えた自然文回答 を返します。

AIモード(AI Mode)とAI による概要(AI Overviews) は「検索への送客」を前提に共通の土台(品質・スパム対策、トリガリング、ナレッジ連携)を共有しつつ、前者が要点スナップショット、後者が計画的探索と行動誘導を中核に据えた上位互換 として位置づけられます。

Google検索におけるAI検索の連続体

Google AI による概要 から AI モード への進化的パラダイム

AI による概要

要点スナップショット

SERP上への生成要約差し込み

クイックアンサー型の回答

根拠リンク付き簡潔要約

検索結果への送客優先

標準的な情報ニーズ対応

機能拡張・深化

AI モード

専用タブ型エンドツーエンドAI検索体験

長文・多段階の探索プロセス

マルチモーダル入力対応

フォローアップによる深掘り探索

外部サイトでのタスク完遂支援

予約・購入・申し込みの実行

計画的探索と行動誘導

Gemini系カスタムモデル統合

上位互換として位置づけ

共通基盤インフラストラクチャ

「検索への送客」を前提とした統合システム

品質・スパム対策

Quality & Anti-spam Systems

トリガリングシステム

Intelligent Triggering Logic

ナレッジ連携

Knowledge Graph Integration

安全システム

Safety & Security Framework

根拠リンクを備えた自然文回答の提供

AI による概要 と AI Mode の違い

Google Search における次世代AI検索

Google検索のAI

AI による概要

検索結果統合型の生成要約機能

要点のまとめ + 根拠リンク(ウェブへの送客)

利用者はリンクからより深く学べる設計

技術基盤

Gemini系カスタムモデル

検索特化型チューニング済み

既存システム統合

ランク付け・Knowledge Graph

運用制御システム

ポリシー管理

品質・安全性確保

スパム対策

悪用防止機構

トリガリング制御

表示可否判定

提供価値

信頼性の高い要約と情報源への明確な導線

既存検索エコシステムとの調和的統合

実装イメージ:

生成要約:検索クエリに対する包括的な回答…

AI による概要

AIモード(AI Mode)

専用タブ

推論的・多段的・マルチモーダル検索体験

後続質問(follow-up)による深掘り探索

複雑なクエリと対話的インタラクション対応

拡張機能群

ライブインタラクション

カメラ・会話機能対応

エージェント的タスク

自律的処理実行

個人コンテキスト

オプトイン型パーソナライズ

カスタム可視化

動的データ表現

展開ロードマップ

1. 先端機能をAI Modeで試験導入

2. ユーザーフィードバックによる継続的改善

3. 成熟機能のコア検索への段階的還流

対話フロー例:

初期クエリ:「最新のAI技術トレンドについて教えて」

Follow-up:「特に自然言語処理の進化について詳しく」

AIモード

機能

段階的

移行

相補的(AI による概要が信頼性と既存エコシステムとの調和を重視し、AI Modeが革新的機能の実験・開発基盤として機能)

AIモード(AI Mode)の発火条件

いつ出して、いつ抑制するのか

AIの要約・対話を出すか否かは、クエリの複雑性 や探索性 、センシティビティ(YMYLなど) 、そしてデータボイド(空白領域)の有無を見てゲーティングされます。

ハイリスク領域では、上位の信頼ソースに支えられない場合は従来のウェブ結果へフォールバックする挙動が明記され、品質の担保は既存ランキング+SafeSearch+SpamBrain 等の前段層、またLLM側の一貫性検証・低確信時の抑制 などで多層的に行われます。運用上は人手評価(Quality Rater Guidelines)の観点も継続的改善に反映される前提で設計されています。

AIモード(AI Mode)の発火条件(いつ出して、いつ抑制するのか)

入力クエリ

判定基準

クエリ複雑性

探索性

センシティビティ

(YMYL等)

データボイド有無

品質保証層(AI出力)

既存ランキング

SafeSearch

SpamBrain

一貫性検証

高リスク領域(フォールバック)

信頼ソースなし → 従来のWeb結果へ

低確信時の抑制

AI要約・対話

(品質確認済み)

従来のWeb結果

(フォールバック)

継続的改善

人手評価 (Quality Rater Guidelines)

AIモード(AI Mode)の概観

Planner → Retrieve → Synthesize/Linkify → Control → Interact

Google AIモード(AI Mode)クエリファンアウト 検索

LLMによる並列探索と検証可能な応答生成の統合システム

ユーザークエリ

複雑な多面的質問

単一の問い

LLMクエリ分解システム

“Query Fan-out” 特許実装

サブトピック1

サブトピック2

サブトピック3

キーワード群A

動的生成

文脈認識

キーワード群B

意味拡張

関連性抽出

キーワード群C

概念展開

深層探索

「ウェブの奥行きを掘り下げる」

サブトピック横断での多数の関連検索を同時発行

並列検索実行層

ウェブインデックス

コアランキング

リアルタイムクロール

ナレッジグラフ

構造化エンティティ

バーティカル検索

現実世界データ

ショッピング

マップ

動画

画像

RAG統合層

Retrieval-Augmented Generation

REALM

ORQA

外部証拠の取得

モデルパラメータに依存しない検証

選択的リンク帰属システム

“Generative summaries for search results” 特許

応答断片1: 概要説明

→ ソースA

応答断片2: 詳細データ

→ ソースB,C

応答断片3: 結論

→ ソースD

文・節単位での

精密な根拠リンク

検証可能性の確保

ステートフルチャット

“Search with stateful chat” 特許

会話状態の保持

フォローアップ対応

文脈の継続性維持

ユーザー条件の記憶

マルチモーダルエージェント機能

📷

ライブカメラ

🎤

音声入力

🎯

タスク実行

実世界タスク完遂支援

予約・購入・ナビゲーション

AI Mode 最終応答

包括的な多面的回答

精密なソース帰属付き

「網羅性と深掘りを両立した検証可能な応答」

継続的文脈保持ループ

動的リファインメント

主要コンポーネント:

クエリファンアウト(LLM駆動分解)

並列検索ソース

RAG/外部証拠

選択的リンク帰属

ステートフルチャット

マルチモーダルエージェント

Query Fan-Out(クエリ ファンアウト)

Google AI モード / Deep Search 並列処理システム

ユーザーの元の質問

Original User Query

質問分解エンジン

Query Decomposition Engine

サブトピック 1

分解クエリ

サブトピック 2

分解クエリ

関連クエリ A

並列検索

関連クエリ B

並列検索

深層クエリ

詳細探索

⚡ 同時並列処理 – Parallel Processing

ナレッジグラフ

Knowledge Graph

高品質ランキング

Quality Ranking

既存検索システム

Existing Search

Deep Search モード

数百サイト横断閲覧

統合・横断推論

Integration & Cross-Reference Analysis

完全引用付きレポート

理解しやすい回答 + 高品質リンク

数分で生成完了(Deep Search による詳細分析)

AI モード

Deep Search

1. 質問を分解

2. 並列で実行

3. 結果を統合

4. レポート生成

Query Fan-Out: 質問を複数のサブクエリに分解し、同時並列処理により包括的な回答を生成するアーキテクチャ

AI Modeの中で最も検索らしい新要素は、LLMを用いたクエリ分解と並列探索、いわゆるQuery Fan-Out(クエリ ファンアウト) です。

ユーザの一つの問いを複数のサブトピックに分解し、それぞれに対してキーワードを生成して並列に検索を走らせ、応答の生成中にも新たな支持ページを同定することで、網羅性と深掘りを両立します。

Google自身の説明でも、AI Modeはサブトピック横断で多数の関連検索を同時発行してウェブの奥行きを掘り下げるとされていますし、特許文献でもまさに「LLMにサブトピックとキーワード群を作らせ、並列検索する」手順が明細として開示されています。

取得段では、ウェブインデックスとコアランキングに加えて、Googleのナレッジグラフや各種バーティカル(ショッピング等)から現実世界データを取り込みます。Googleによるとショッピング体験がShopping Graphと統合されると言われており、構造化された実体データが生成応答とリンク提示を支えていることがうかがえます。

Google AIモード(AI Mode) Query Fan-Out(クエリ ファンアウト)

LLMベースのクエリ分解と並列探索システム

ユーザークエリ

単一の複雑な探索的質問

LLM

Query Decomposer

クエリ分解 → サブトピック・キーワード群生成

サブトピック A

キーワード群 α

サブトピック B

キーワード群 β

サブトピック C

キーワード群 γ

サブトピック N

キーワード群 ω

並列検索実行

サブトピック横断で同時にウェブの奥行きを探索

ウェブインデックス

コアランキング

深層ウェブ探索

ナレッジグラフ

構造化エンティティ

関連性データ

Shopping Graph

商品データ統合

現実世界データ

各種バーティカル

専門領域データ

ドメイン特化情報

応答生成・統合処理

網羅性と深掘りの両立 | 動的な支持ページ同定

AI生成応答 + 関連リンク提示

構造化された実体データに基づく包括的回答

継続的

最適化

システム特性

LLMによるインテリジェントな分解

並列処理による高速探索

多層データソースの統合

特許文献記載:「LLMによるサブトピック・キーワード群生成と並列検索実行」手法の実装

特許明細書記載の

クエリ分解処理

Google公式発表の

Shopping Graph統合

RAGで外部証拠を都度取りに行って応答を検証可能にする

背景にある学術的な系譜は、REALMやORQAに代表されるRetrieval‑Augmented Generation(RAG)の発想で、モデル内部のパラメータだけに知識を閉じず、外部証拠を都度取りに行って応答を検証可能にするという考え方です。

REALM: Retrieval-Augmented Language Model Pre-Training

検索拡張生成(RAG)

外部証拠を都度取得して応答を検証可能にする

Retrieval-Augmented Generation Architecture

外部知識リポジトリ・エビデンスソース

REALM

検索拡張型

言語モデル

事前学習

Pre-Training

ORQA

オープン検索

質問応答

システム

Open-Retrieval QA

学術文献

研究論文

技術文書

参考資料

Academic Papers

知識ベース

構造化データ

専門知識

ドメイン情報

Knowledge Base

動的検索・取得メカニズム

クエリに応じて必要な外部証拠を都度取得

Dynamic Retrieval Component – Evidence Retrieved on Demand

ユーザークエリ

質問・要求

言語モデル

RAG統合型LLM

Language Model with RAG

検証可能な応答

証拠付き回答

取得した外部証拠

Retrieved Evidence

出典: REALM論文

出典: ORQAデータセット

出典: 学術文献

入力

検索要求

証拠取得

生成

システムの核心原理

モデル内部のパラメータだけに知識を閉じず、外部証拠を都度取得することで検証可能性を実現

LLMが検索結果群を自然文にまとめつつ、その文や節の単位で根拠ページにリンクを張る選択的リンク化

統合と要約では、LLMが検索結果群を自然文にまとめつつ、その文や節の単位で根拠ページにリンクを張る選択的リンク化が鍵になります。

Googleが取得した「Generative summaries for search results」特許は、まさにこの処理系を図解と手順で記述しており、要約の断片に信頼できる検証用リンクを帰属させる仕組みを明確に示しています。AIモード(AI Mode)/AI による概要(AI Overviews) の応答にリンクが多様に付く設計は、ここで説明される帰属(Attribution)機構と整合的です。

Generative summaries for search results(US 11,769,017 B1 )

LLM選択的リンク化(検索結果の自然言語統合と帰属メカニズム)

Generative summaries for search results (US 11,769,017 B1)

検索結果群

1

技術文書サイト

最新のAPI実装ガイドラインと

エンタープライズ向けの

ベストプラクティスを提供

https://docs.example.com/api/v3

2

研究論文

深層学習モデルの最適化により

ベンチマークテストで

95.8%の精度を達成

https://arxiv.org/papers/2024.1234

3

市場分析レポート

2027年までにAI導入率が

企業セクター全体で

300%増加すると予測

https://report.analytics.jp/ai-2024

4

製品リリースノート

v5.2アップデートで

リアルタイム処理機能を追加

パフォーマンス50%向上

https://blog.platform.io/release/v5.2

5

業界ニュース

大手企業のAI活用事例と

導入効果の詳細分析

LLM処理エンジン

帰属処理パイプライン

1. コンテンツ抽出・分析

2. 意味的チャンキング

3. 自然言語生成

4. 文・節レベルの帰属割当

5. リンク埋め込み処理

6. 品質・一貫性チェック

選択的リンク付き要約

本システムは最新の

API実装技術

1

を活用し、

エンタープライズグレードのパフォーマンスを

実現しています。研究によると、

深層学習の精度は95.8%

2

に達し、

業界標準を大幅に上回っています。

市場分析では、

2027年までに300%の成長

3

が

予測されており、AI導入が急速に進んでいます。

最新の

v5.2アップデート

4

により、リアル

タイム処理が可能となり、パフォーマンスが

50%向上しました。また、

大手企業の事例

5

では、

実装による効率化が確認されています。

帰属(Attribution)メカニズムの特徴

文・節レベルの精密さ:各主張を特定のソースにリンク

自然な流れの維持:リンクは文章の流れを妨げない

検証可能性:ユーザーは即座に情報源を確認可能

信頼性向上:透明な情報源により信頼度が向上

AI Overviews統合:検索結果に自然に統合

抽出・分析

生成・帰属

実装の重要ポイント

• 透明性:生成された全ての文が信頼できるソースに追跡可能

• 粒度:文・節レベルでの精密な検証を実現

• 自然言語:引用を埋め込みながら読みやすさを維持

• 選択的リンク:戦略的な配置で流れと理解を保持

• ユーザー信頼:即座の検証で信頼性を向上

• 特許準拠:Google US 11,769,017 B1に準拠

会話状態を保持してAIモード(AI Mode)でのフォローアップに反映する

対話の継続に関しては、会話状態を保持してフォローアップに反映する「Search with stateful chat」特許が示唆的です。

生成的なコンパニオンが検索セッションの文脈やユーザの条件を維持し、再検索や追加の論点展開を行う挙動が記述されています。AI Modeでフォローアップを重ねても文脈が保たれ、より深い比較や具体的な計画に進めるのは、この思想の具現と見なせます。

Search with Stateful Chat(US 2024/0289407 A1 )

AIモード(状態保持型対話)

会話状態を保持してフォローアップに反映する仕組み

AIモード

状態管理エンジン

文脈:アクティブ

ユーザーの問いかけ

1

初期検索

検索セッション開始

2

条件を維持・追加

再検索と絞り込み

3

より深い比較

追加の論点展開

4

具体的な計画

アクションプラン策定

AIの応答

A

初期結果

文脈:基本

A+B

洗練された結果

文脈:拡張済み

A+B+C

比較分析

文脈:包括的

完全

行動計画

文脈:完全スタック

コア機能

文脈維持 • 再検索 • 追加の論点展開 • 累積的理解

Search with Stateful Chat

US 2024/0289407 A1

さらに、AIモード(AI Mode)は視覚・音声を含むマルチモーダル入力や、実世界のタスク完遂を支援するエージェント的機能へも拡張しています。

ライブなカメラ入力と対話で状況を理解し、必要に応じて外部サイトで予約や購入を完了させるためのリンクをいつ提示するかを学習するという設計が、公式ブログやPDFに明記されています。これにより、情報獲得だけでなく行動の最短経路へユーザを導く役割が、検索の内部で徐々に一般化しています。

AIモード

マルチモーダル入力 • エージェント機能 • 実世界タスク完遂

AI処理エンジン

状況理解システム

ライブカメラ

視覚認識

音声入力

対話認識

状況データ

コンテキスト分析

情報獲得

検索・分析

外部リンク

予約・購入

タスク完遂

実世界アクション

学習フィードバック

タイミング最適化

情報収集

状況理解

行動実行

ユーザー目標への最短経路

システム概要

入力系統

処理中枢

出力系統

学習機能

AIモード(AI Mode)の概念的データフローは次の通りです。

Planner → Retrieve → Synthesize/Linkify → Control → Interact

概念的データフローとクエリ処理パイプライン

プランナー

取得

合成/

リンク化

制御

対話

トリガリング

AI表示可否判定

制約条件チェック

(YMYL抑制等)

クエリファンアウト クエリ自動分解

意味的サブトピック

生成・展開

並列検索

各サブトピック

独立並列処理

データソース

ウェブ索引

ナレッジグラフ

ショッピンググラフ

構造化データ

根拠候補集合

ランキング処理

スパム防御

選別・正規化

LLM処理

自然文要約生成

文/節単位処理

根拠URL

選択的リンク化

会話状態管理

状態保持

フォローアップ

意図変化追跡

安全・ポリシー層

出力制御

ポリシー適用

通常検索回帰

ユーザー対話

結果表示

対話継続

フィードバック

継続対話フィードバックループ

システム特性

意味的クエリ分解による高精度検索

並列処理による高速レスポンス

複数データソースの統合活用

根拠ベースの信頼性高い応答

リアルタイム安全性制御

状態保持による継続的対話

選択的リンク化による透明性確保

適応的な通常検索へのフォールバック

統合型AI検索システム:意味的クエリ分解と並列処理による高速・高精度情報取得

ナレッジグラフ・ショッピンググラフ・ウェブ索引の統合による根拠ベース応答生成

会話状態管理と安全性制御による信頼性の高い継続的対話体験の実現

AI検索 概要

高レベルデータフロー & 処理パイプライン

1

クエリ受理 & 表示判定

Triggering/Gating

意図分析・YMYL感度検出

データボイド評価

AI要約 vs 通常リンク判定

2

クエリ展開

Query Fan-Out: q → T={t₁, t₂, …, tₙ}

LLMサブトピック生成

並列検索実行

生成→検索→生成(RAG)

3

マルチソース検索 & ナレッジ連携

根拠集合の形成

ウェブ索引・Knowledge Graph

Shopping Graph・構造化データ

リアルワールドデータ統合

7

マルチモーダル/ライブ

Project Astra

Search Live・カメラ

音声・視覚入力

多モーダル推論

4

品質/スパム防御の統合

ランキングシステム

SpamBrain(AI型スパム対策)

政策違反検出

E-E-A-T評価

Search Quality Rater

Guidelines適用

5

生成要約(LLMオーケストレーション)

検索結果集合→LLMプロンプト

自然言語要約

根拠リンク(Linkifying)

複数モデル選択

一貫回答の検証

キャッシュ/正準化

6

会話・状態保持(Stateful Chat/Generative Companion)

セッション状態永続化(Embedding)・合成クエリ生成

文脈に応じた下流モデル選択・Follow-up機能

個人コンテキスト統合

AIによる概要 / AI Mode 出力

根拠に基づくグラウンデッドサマリー+引用リンク

品質・安全保護層適用済み

開発者向け統合: Google Search Webグラウンディング・Vertex AI RAG/グラウンディングドキュメント

コアパイプライン: 生成→検索→生成(特許文書化されたRAGベースアプローチ)

Query Fan-Out(クエリ ファンアウト)

計画的探索のコア

AIモード(AI Mode)の差異化点は、LLMがクエリをサブトピック集合 に展開し、それぞれにキーワード集合 を与えて並列に検索 する点です。

特許「Utilizing a LLM to perform a query」は、サブトピック生成→キーワード生成→並列検索→候補文抽出→再要約 という骨格を明示し、Google公式の解説でもAI Modeの中核手法としてFan‑Outが説明されます。これにより、単一SERPでは得にくい高被覆(coverage)×深掘り が実現します。

Query Fan-Out(クエリ ファンアウト。計画的探索のコア)

AI Mode差異化技術

初期クエリ

LLM

サブトピック1

サブトピック2

サブトピック3

サブトピック4

サブトピック5

サブトピック6

サブトピック7

キーワード集合

キーワード集合

キーワード集合

キーワード集合

キーワード集合

キーワード集合

キーワード集合

並列検索

再要約

高被覆(coverage)× 深掘り

単一SERPでは得にくい包括的結果

1. サブトピック生成

↓

2. キーワード生成

3. 並列検索

4. 候補文抽出

5. 再要約

特許「Utilizing a LLM to perform a query」 | Google AI Mode実装

FAN-OUT + RAG

大規模実運用版RAGシステム

ユーザクエリ入力

q

サブトピック生成 (LLM)

T = {t₁, t₂, …, tₘ} ← LLM_expand(q)

各 tᵢ にキーワード集合 Kᵢ が付随

(特許明記のキーワード関連付け)

t₁, K₁

サブトピック 1

t₂, K₂

サブトピック 2

tᵢ, Kᵢ

サブトピック i

tₘ₋₁, Kₘ₋₁

サブトピック m-1

tₘ, Kₘ

サブトピック m

並列検索

Rᵢ,ⱼ = Retrieve(tᵢ, Kᵢ, Dⱼ)

Web索引

D₁

ナレッジ

グラフ D₂

ショッピング

グラフ D₃

マップ/ローカル

D₄

ニュース

D₅

ファイナンス

D₆

スカラー

D₇

•••

Dⱼ

統合 & フィルタリング

S = Select(⋃ᵢ,ⱼ Rᵢ,ⱼ)

ランキング • SpamBrain • ポリシー適用 • 重複排除

キーワード被覆スコアリング • 関連度フィルタリング • 品質評価

生成 & 要約 (LLM)

y = LLM_summarize(q, S)

根拠リンク化(文単位) • 一貫性検証 • 確信度スコアリング

低確信時のフォールバック → 通常検索結果 • レスポンスキャッシュ • レイテンシ制御 (τ)

トピック展開

m個のサブトピック生成

ファンアウトパターン

並列処理

m × j 検索

クロスプロダクト検索

品質管理

多段階フィルタリング

レスポンス合成

帰属認識型

AIモード(AI Mode)におけるマルチソース検索とRAG的統合

外部証拠を必ず取りに行く

取得フェーズはウェブだけでなくナレッジグラフや各種バーティカル(例:Shopping Graph)の構造化データを併用します。

この思想は、Retrieverと生成を密結合するRAG系研究(REALM/ORQA)の系譜と整合し、「外部証拠で要約をグラウンディング する」ことを製品レベルで標準化したものと捉えられます。

REALM: Retrieval-Augmented Language Model Pre-Training

マルチソース検索とRAG的統合

外部証拠を必ず取りに行くシステム

製品レベルで「外部証拠による要約のグラウンディング」を標準化

ユーザークエリ

取得フェーズ

マルチソースデータオーケストレーション

構造化・非構造化データの統合取得管理

ウェブ検索

非構造化データ

文書・ページ

リアルタイム情報

KG

ナレッジグラフ

構造化事実

エンティティ ・関係性

Shopping Graph

ショッピンググラフ

商品データ

在庫・価格情報

バーティカル

各種専門領域

ドメイン特化

専門データベース

+

RAG統合レイヤー

Retrieverと生成を密結合

REALM/ORQA研究系譜との整合性

グラウンディング生成

外部証拠で要約をグラウンディング

コアイノベーション

製品レベルでの

標準化実装

外部証拠による

グラウンディングが

アーキテクチャの

デフォルト動作に

クエリ受付

オーケストレーション

証拠取得・統合

証拠基盤生成

AIモード(AI Mode)の生成・帰属(Attribution)

文単位リンク化による検証可能性

特許「Generative summaries for search results」は、検索結果集合→LLM要約→要約断片の選択的リンク化 を図解で記述します。

AI Mode/Overviewsの回答に多様な出典リンク が付く振る舞いは、この文/節単位の帰属 の結果です。

さらに運用特許(Search with Generative AI)は、低確信時のフォールバック、要約の正準化/キャッシュ、複数モデル選択、レイテンシ予算に応じた入力剪定 といった実務上の工夫を開示しています。

生成・帰属(Attribution。文単位リンク化による検証可能性)

Generative Summaries for Search Results Patent Architecture

検索結果集合

Source 1: 研究論文データベース

Source 2: 技術ドキュメント

Source 3: API仕様書

LLM 要約

LLM

統合処理・要約生成

要約断片の選択的リンク化

「処理速度が従来比30%向上」

[Source 1]

「並列処理により効率化を実現」

[Source 2]

「RESTful APIで非同期処理対応」

[Source 3]

AIモード(AI Mode)/AI による概要(AI Overviews)

多様な出典リンク付き回答の生成

文/節単位の帰属による検証可能性の実現

運用特許(Search with Generative AI)- 実務上の工夫

低確信時のフォールバック

確信度スコアの評価

閾値以下での代替処理

品質保証メカニズム

要約の正準化/キャッシュ

標準形式への変換

頻出クエリの結果保存

応答時間の最適化

複数モデル選択

タスク特性の分析

最適モデルの動的選択

性能とコストのバランス

レイテンシ予算に応じた

入力剪定

処理時間制約の評価

入力データの優先順位付け

効率的な情報抽出

システムの主要特性

検索結果からの高精度要約生成

文単位での出典管理

完全な検証可能性

実用的最適化の実装

リアルタイム性能保証

スケーラブルアーキテクチャ

品質と速度の両立

AIモード(AI Mode)における会話状態と個人文脈

Stateful ChatとAgentic機能

「Search with stateful chat」特許は、セッション状態の保持、合成クエリ生成、文脈に応じた下流モデル選択 を記載します。

AIモード(AI Mode)ではフォローアップを重ねても文脈が保たれ、必要に応じライブ(カメラ)や音声 を含むマルチモーダル入力にも対応し、将来的にはAgentic(タスク代行)能力を通じて「いつ外部リンクで行動を完遂させるか 」までを学習的に最適化する方向が示されています。

Stateful ChatとAgentic機能

会話状態保持と自律的タスク実行システム

セッション状態

管理システム

SESSION STATE

合成クエリ生成

エンジン

Synthetic Query

下流モデル選択

文脈適応型

Downstream Model

マルチモーダル入力処理

ライブ/カメラ

音声入力

テキスト入力

AIモード稼働中

フォローアップ文脈保持

Context Retention

Agentic機能フレームワーク

自律的タスク実行と外部リンク行動完遂の学習的最適化

Autonomous Task Execution and External Action Optimization

タスク代行

外部リンク

学習最適化

行動完遂

AIモード(AI Mode)の形式化

AI Modeの中核(Fan‑Out+RAG)を簡潔に形式化します。

ユーザクエリ \(q\) に対し、LLMによるサブトピック展開

$$T=\{t_i\}_{i=1}^m \leftarrow \mathrm{LLM\_expand}(q),\qquad K_i=\mathrm{LLM\_keywords}(t_i)$$

を行い、データ源 \(D=\{D_j\}\) に対する並列取得

$$R_{i,j}=\mathrm{Retrieve}(t_i,K_i,D_j)$$

で候補集合を作ります。

ランキング・スパム防御・重複排除で選別した集合 \(S\) を要約器に入力して $$y=\mathrm{LLM\_summarize}(q,S)$$

を得、要約の各断片 \(y_k\) に帰属関数 \(LL で出典URLを付与します(選択的リンク化 )。

YMYL等では品質スコア \(Q(S)\) に基づく閾値 \(\tau\) で抑制/フォールバック を行います。

ここでの最適化目標は被覆(coverage)・一貫性(consistency)・行動可能性(actionability)の三者のバランスと言えます。

AI Mode 形式化モデル(Fan-Out + RAG )

AIモード(AI Mode)要約モデル – 数理的形式化

q

ユーザクエリ

LLMサブトピック展開

LLM_expand(q)

T = {t₁, t₂, …, tₘ}

Kᵢ = LLM_keywords(tᵢ)

サブトピック分解 (Fan-Out)

t₁

キーワード集合: K₁

t₂

キーワード集合: K₂

tₘ

キーワード集合: Kₘ

⋮

データ源集合

D = {Dⱼ}

D₁

D₂

Dⱼ

並列取得処理

Rᵢ,ⱼ = Retrieve(tᵢ, Kᵢ, Dⱼ)

┌ ┐

R₁,₁ R₁,₂ … R₁,ⱼ

R₂,₁ R₂,₂ … R₂,ⱼ

⋮ ⋮ ⋱ ⋮

Rₘ,₁ Rₘ,₂ … Rₘ,ⱼ

└ ┘

候補集合の生成

処理パイプライン

• ランキング関数適用

• スパム防御フィルタ

• 重複排除 → 集合 S

LLM要約生成

y = LLM_summarize(q, S)

要約出力生成

帰属関数 L の適用

L: yₖ → URL

(選択的リンク化)

品質管理システム

Q(S) ≥ τ

YMYL抑制/フォールバック機構

最適化出力

✓ 被覆 (Coverage)

✓ 一貫性 (Consistency)

✓ 行動可能性 (Actionability)

数式による形式化

1. クエリ展開プロセス:

T = {tᵢ}ᵢ₌₁ᵐ ← LLM_expand(q)

Kᵢ = LLM_keywords(tᵢ)

2. 並列取得オペレーション:

Rᵢ,ⱼ = Retrieve(tᵢ, Kᵢ, Dⱼ)

各サブトピックとデータ源の組み合わせで実行

3. 候補選別プロセス:

S = dedupe(rank(filter(⋃ᵢ,ⱼ Rᵢ,ⱼ)))

4. 要約生成と帰属付与:

y = LLM_summarize(q, S)

L: yₖ → URL (選択的リンク化)

5. 品質制御メカニズム:

if Q(S) ≥ τ then output(y) else fallback()

最適化目標関数 argmax { 被覆(y,q) × 一貫性(y) × 行動可能性(y) }

AIモード(AI Mode)のAIモデル

Gemini 2.x、Deep Search、Live、Personal Context

I/O 2025以降、Gemini 2.x(2.0/2.5)は長文脈・推論・ツール使用・エージェント的能力を強化し、AIモード(AI Mode)/AI による概要(AI Overviews) にはカスタム版Gemini が投入されています。

さらにDeep Search (非常に多くのfan‑outで専門的レポートを生成)、Live(Astra系のカメラ・音声対話) 、Personal Context(同意に基づく個人文脈の活用)など、先端機能をまずAIモード(AI Mode)で提供し、成熟後にコア検索へ還流させるロードマップが示されています。

モデルと機能の進化(Gemini 2.x と先端機能展開)

I/O 2025 以降の戦略的ロードマップ

Gemini 2.x

(2.0 / 2.5)

長文脈

推論

ツール

使用

エージェント

的能力

Deep Search

極端な fan-out で

専門的レポート生成

Live (Astra系)

カメラ・音声対話

リアルタイム応答

Personal Context

明示同意に基づく

個人文脈の活用

AI Mode / Overviews

カスタム版 Gemini による実験的機能展開プラットフォーム

先端機能投入

ユーザー検証

データ収集

機能成熟化

統合準備

コア検索への統合

成熟した機能の段階的展開と一般ユーザーへの提供

成熟後に還流

現在

実験・検証段階

完全統合

Gemini 2.x Evolution

Agentic Capabilities & Strategic Implementation

GEMINI

2.0

Initial Release

GEMINI

2.5

Enhanced Version

Core Technical Capabilities

推論強化 (Enhanced Reasoning)

長文脈 (Extended Context)

ツール使用 (Tool Integration)

エージェント的能力 (Agentic)

AIモード / AI による概要

Custom Gemini Integration

カスタム版Gemini

I/O 2025

Industry-Leading Performance

最速クラスの応答

Response Speed Performance

Google Gemini 2.x Series | 2025

サイト運営者のAI Mode(AIモード)対策

専用スキーマ不要、計測は「Web」タイプ

AIモード(AI Mode)/AI による概要(AI Overviews)に専用マークアップは不要 です。原則は通常のSEOベストプラクティス(インデックス可能(noindex/robotsの誤設定がない)、スニペット許可(nosnippet等の抑止は最小限に)、構造化データ=可視テキスト一致 、良好なCore Web Vitals )を満たすこと。

計測はSearch Consoleのパフォーマンス(検索タイプ=Web)に合算され、AI専用レポートではありません。Googleは開発者向けに「AI体験で成果を上げるための要点」も提示しており、可視テキストの充実・構造化の整合・動画や画像の適切なメタデータ など、従来原則の徹底が最短路であることを強調しています。

AIモード(AI Mode)/AI による概要(AI Overviews) 対策の方針

専用マークアップ不要 — 通常のSEO原則で対応

通常SEO

ベストプラクティス

1

インデックス可能

noindex設定なし

robots.txt適切設定

クロール可能な構造

2

スニペット許可

nosnippet最小限に

抜粋表示を許可

コンテンツ活用可

3

構造化データ

可視テキスト一致

Schema.org準拠

正確な実装

4

Core Web Vitals

LCP(読込速度)

FID/INP(操作性)

CLS(視覚的安定性)

SC

計測:Search Console パフォーマンスレポート

検索タイプ「Web」に合算表示 — AI専用レポートは存在しません

Google推奨(AI体験での成功要因)

可視テキストの充実

構造化データの整合

動画・画像メタデータ

→ 従来のSEO原則の徹底が最短路

AIモード(AI Mode)の実装インプリケーション

被覆・引用可能性・行動完遂の三本柱

AIモード(AI Mode)は計画的なFan‑Out と文単位リンク化 で回答を合成するため、サイト側はこの構造に同型 の情報設計を与えると効果的です。

第一に、ページ冒頭に「一文一主張+根拠リンク」の要点列(3〜7文)を置き、表・手順は 画像化せずテキストで提供します(引用可能性の最大化)。

第二に、比較/方法/費用(価格)/代替/リスク/地域/期限といった意図軸で被覆マップを内製し、空白領域を継続的に埋めます(被覆の最大化)。第三に、相談予約・見積・購入・申込などの完了ページを 最短導線(3クリック以内)・高速(INP等の改善)・構造化整合で磨きます(行動完遂の最大化)。

動画はClip/SeekToAction+字幕(VTT)による Key moments実装で、該当秒へのディープリンクを用意すると比較・手順クエリで採用されやすくなります。

運用面では、GSCの「AI候補」クエリ・セグメント(長文・比較・計画等の含有語)を作り、CTR/平均掲載/滞在/CVRとVideo IndexingのKey moments有効化率 を週次で確認、月次で被覆ギャップを埋めるサイクルを回すのが実務的です。

実装インプリケーション

被覆・引用可能性・行動完遂の三本柱

AI Mode基本構造:計画的なFan-Out × 文単位リンク化

サイト側は同型の情報設計を与えることで効果を最大化

引用可能性の最大化

一文一主張+根拠リンク

ページ冒頭に3〜7文の要点列を配置

表・手順のテキスト化

画像化を避けて引用可能性を確保

文単位リンク化の実装

AI Modeの引用構造に最適化

成果指標:引用採用率の向上

被覆の最大化

意図軸での被覆マップ内製

体系的なコンテンツカバレッジ設計

比較/方法

費用/代替

リスク/地域

期限/条件

空白領域の継続的補完

成果指標:被覆完全性の向上

行動完遂の最大化

最短導線の実現

3クリック以内での完了ページ到達

高速化と構造化整合

INP改善による体験最適化

相談予約・見積・購入・申込の最適化

成果指標:CVR・完了率の向上

動画実装戦略

Clip/SeekToAction + VTT字幕

Key moments実装

GSC運用モニタリング

AI候補クエリ・セグメント

CTR/平均掲載/滞在/CVR

運用サイクル

週次確認

メトリクス分析

月次評価

ギャップ補完

主要成果指標

Key moments有効化率

被覆ギャップ改善率

平均滞在時間向上

CVR改善率

AIモード(AI Mode)のトレードオフと評価

速度・確信・品質のバランス

AIモード(AI Mode)は最速クラスの応答 を掲げる一方、特許群にはレイテンシ予算に応じた入力剪定 やバックグラウンド要約 、低確信時のフォールバック が明示され、速度・品質・確信度の三者トレードオフを運用で最適化していることが分かります。

サイト側も、被覆の広さ (上流の召喚率)と要点列の精度 (引用率)と完了ページの応答性 (CVR)を、小さなA/BとKPI監視 でバランスよく上げ続ける発想が必要です。

トレードオフと評価(速度・確信・品質のバランス)

Tradeoff and Evaluation: Balancing Speed, Confidence, and Quality

最適化ポイント

速度

Speed

最速クラスの応答

確信度

Confidence

品質

Quality

技術的最適化

Technical Optimizations

レイテンシ予算に応じた

入力剪定

低確信時の

フォールバック

バックグラウンド要約

サイト側指標

Site-side Metrics

被覆の広さ

(上流の召喚率)

要点列の精度

(引用率)

完了ページの

応答性

(CVR)

継続的最適化プロセス

Continuous Optimization Process

小さなA/Bテスト

KPI監視

RAG+Planner+Attributor+Controller=検索の仕組み

AIモード(AI Mode)はRAG的外部証拠取り込み を中核に、LLMプランナー(Fan‑Out)で被覆を確保し、Attributor(文単位のリンク化)で検証可能性を担保し、Controller(安全・ポリシー)で出力と表示を制御する、検索の仕組みです。

AIモード(AI Mode)はウェブ全体を外部知識ベースとして扱うRAGの枠組みに、LLMプランナーによるQuery Fan-Out(クエリ ファンアウト) と、生成文の断片に検証用リンクを付すアトリビュータを組み合わせ、さらに安全・品質のコントローラで出力と表示を制御する検索の仕組みへと進化した姿と捉えられます。

従来のGoogle検索と連続性を保ちながら、ユーザの情報要求を計画的な探索と行動の完遂に接続する構造が、公式資料・研究・特許のいずれにも裏づけられています。

サイト運営側にとっては、特別なマークアップを追うよりも、引用可能性と被覆の設計、完了ページの体験品質、そして「ウェブ」タイプの計測という土台を磨くことが、AIモード(AI Mode)時代の最短距離になります。

学術(REALM/ORQA・Socratic Models)と特許群(fan‑out・generative summaries・stateful chat・運用制御)がそれを裏づけ、実装の最短路は専用スキーマ探しではなく「被覆×引用可能性×行動完遂性 」の正攻法の徹底にあります。

検索の仕組み

AI Mode 統合検索システム

RAG + Planner + Attributor + Controller = 検索の仕組み

入力

RAG

外部証拠取り込み

検索拡張生成

REALM/ORQA

ソクラテスモデル

Planner

LLM Fan-Out

被覆確保

並列処理展開

クエリ拡張

Attributor

文単位リンク化

検証可能性担保

引用管理

ソース検証

Controller

安全・ポリシー

出力・表示制御

コンプライアンス

運用制御

出力

検索の仕組み

統合検索オペレーティングシステム

学術的基盤

• REALM/ORQA – 検索拡張言語モデル

• Socratic Models – マルチモーダル推論

• 密集文書検索・ニューラルIRシステム

特許技術群

• Fan-out処理 – 並列クエリ展開技術

• Generative Summaries – 動的要約生成

• Stateful Chat・運用制御システム

実装原則

被覆 × 引用可能性 × 行動完遂性 = 正攻法の徹底

専用スキーマ探しではなく、基本原理の確実な実装

AIモード(AI Mode)の実装上のトレードオフと推定

IMPLEMENTATION TRADE-OFFS AND ESTIMATIONS

速度–品質トレードオフ

SPEED-QUALITY

レイテンシ予算に応じた入力剪定

Dynamic input pruning based on latency budget

バックグラウンド要約の並列処理

Parallel background summarization processing

→ AI Mode “最速クラス” の実現

確信度によるフォールバック

CONFIDENCE FALLBACK

低確信度の自動検出システム

Automatic low-confidence detection system

ウェブ結果のみへの即座切替

Instant fallback to web-only results

→ 品質保証ガード機能

評価と改善

EVALUATION & IMPROVEMENT

Lab Testing

段階的ロールアウト

人手評価

事実性の継続的検証と改善

鮮度情報の定期的更新サイクル

→ 継続的改善パイプライン

安全/コンプライアンス

SAFETY & COMPLIANCE

YMYL領域への厳格な制御機構

Your Money Your Life domain controls

有害コンテンツのトリガ制御/抑止

Harmful content trigger controls and suppression

SpamBrainによる前段防御システム

SpamBrain pre-filtering defense system

→ 多層防御

AIモード

AI Mode

Google検索

Google Search AI Patents Implementation Architecture

生成と検索の密結合設計を実現する特許技術群

Generative Summaries

US 11,769,017 B1

検索結果のLLM処理システム

• 検索結果をLLMに入力して要約生成

• 部分的リンク化による参照機能

• ユーザ操作後の動的再要約

• 複数モデルの選択と切替

• セッション文脈の継続的活用

LLM Query Processing

US 12,019,663 B1

Fan-out型RAG

• サブトピック&キーワード自動生成

• 並列検索による効率的処理

• 文抽出と選択的処理

• LLMによる階層的再要約

• 分散処理による高速化

Search with Generative AI

US 2024/0256582 A1

運用最適化メカニズム

• 要約生成トリガの動的制御

• 整合性検証システム

• 正準化保存による効率化

• レイテンシ制御機構

• パフォーマンス最適化

Stateful Chat

US 2024/0289407 A1

対話型インターフェース

• 生成コンパニオン機能

• 状態保持メカニズム

• 合成クエリ生成

• 文脈的モデル選択

• 継続的対話サポート

Google Search

AI Mode / AI による概要

統合実装プラットフォーム

統合実装による主要機能

Fan-out型RAG

並列検索と階層的要約により

効率的な情報統合を実現

複数ソースからの知識を

動的に統合処理

マルチモーダル対応

テキスト・画像・動画を

シームレスに統合処理

各メディアタイプに最適化された

処理パイプライン

Follow-up機能

文脈を保持した継続的対話

ユーザーの意図を理解し

関連する追加情報を

プロアクティブに提供

密結合設計

生成AIと従来検索の

リアルタイム統合

最適な情報源を

動的に選択・結合

AIモード(AI Mode)に関連する研究と特許

AIモード(AI Mode)のテクニカルルートマップ

AI Modeのらしさを支える根拠は、公開特許と研究に明確に現れています。

クエリをサブトピックとキーワードに分解して並列検索するという「Utilizing a large language model to perform a query」は、内部で起きているプランニングの実装例として最も直接的です。

Utilizing an LLM to perform a query(US 12,019,663 B1 )

検索結果をLLMで要約し、自然文の断片へ選択的に検証用リンクを付す「Generative summaries for search results」は、現在の帰属の仕組みをそのまま図示しています。

Generative summaries for search results(US 11,769,017 B1 )

会話文脈を維持する「Search with stateful chat」は、フォローアップを重ねるAI Modeの体験設計と合致します。

Search with Stateful Chat(US 2024/0289407 A1 )

学術的には、REALMやORQAが外部証拠を取ってくる言語モデルの枠組みを確立し、検索×生成が検証可能性を獲得するための理論的な梯子となっています。

REALM: Retrieval-Augmented Language Model Pre-Training